Si estás iniciándote dentro del mundo del SEO o simplemente quieres ampliar conocimientos, seguro que más de una vez te has preguntado sobre qué es un archivo robots.txt y cuáles son sus funcionalidades.

En nuestro post de hoy vamos contar todo lo que tienes que conocer sobre el archivo robots.txt. ¡Sigue leyendo para descubrirlo!

Qué es el archivo robots.txt

El robots.txt es un archivo de texto que se encuentra ubicado en la raíz de un dominio y tiene como objetivo principal controlar el acceso de los distintos rastreadores de los motores de búsqueda a nuestro sitio web. Es decir, es un archivo que cuenta con una serie de comandos, a través de los cuales indica a los bots o crawlers a qué sitios no tienen permitido el acceso, e incluso se pueden detallar secciones o carpetas a las que no se puede acceder (disallow) o si se puede acceder (allow) o tipos específicos de rastreadores web, como pueden ser los rastreadores de mobile o desktop.

Para qué sirve el archivo robots.txt

Como se comenta en el párrafo anterior, es un elemento con el que dar órdenes a los distintos bots que existen en Internet. De cara al SEO podemos decir que es uno de los archivos más importantes, a continuación enumeraremos sus funciones específicas:

Controlar el acceso a las páginas web

En la gran mayoría de sitios webs existen páginas que seguro no nos interesa que sean rastreadas, bien porque directamente su contenido es irrelevante o simplemente son páginas restringidas que no queremos hacer públicas, para ello se utiliza el robots.txt.

También podemos regular la frecuencia y hora de acceso de los bots al contenido de la web, tratando de evitar de esta manera posibles caídas del servidor. Ya que si el crawleo de algún tipo de araña se da durante una tramo horario el cual coincide con un pico de visitas a la web, puede provocar un exceso de solicitudes al servidor que no pueda afrontar, y este caiga o de error, generando pérdidas económicas.

Bloquear el acceso a los archivos de recursos

En un dominio también existen varios archivos como pueden ser los de imagen que cuentan con información importante (infografías o una ficha técnica), y a través del robots.txt podemos evitar que aparezcan en los resultados de búsqueda.

Optimizar el presupuesto de rastreo (Crawl Budget)

Otra de las funciones de este tipo de archivo, tiene que ver con la optimización del presupuesto o tiempo de rastreo que le dedican los rastreadores web a un sitio.

Por ejemplo, en el caso de Google, a la hora de rastrear el contenido de una web, cuenta con un tiempo determinado, por lo que en ese proceso de crawleo interesa que se lea el contenido de nuestras principales páginas, y no pierda el tiempo en URLs intranscendentes.

Esto se puede ver claramente reflejado en webs con miles o millones de URLs como puede ser un e-commerce. Es decir, existen sitios para los cuales hay que priorizar el rastreo debido a la gran cantidad de contenido del que disponen, para ello, el robots.txt es un elemento imprescindible ya que nos permite bloquear carpetas o directorios en los que no interese perder ese preciado tiempo de rastreo.

Comandos del archivo robots.txt

Los comandos utilizados funcionan de manera similar a los usados en lenguajes de programación como HTML. Estos son algunos de los comandos principales:

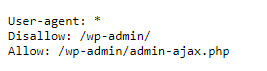

Comando User-Agent

Indica para qué robots se aplican las reglas que a continuación vienen especificadas. En caso de que las reglas apliquen para todos, directamente se usa user-agent:*.

Comando Disallow

Indica al user-agent a donde no tiene permitido el acceso, rastreo ni indexación. Puede ser un directorio concreto, subdirectorio o URL específica.

Comando Allow

Su función es la contraria al comando anterior, ya que indica donde si tiene permitido el acceso, rastreo e indexación.

Comando Sitemap

A través de este comando le indicaremos la ruta donde se encuentra el sitemap de nuestro sitio web.

Ahora que sabes qué es y cómo funciona un archivo robots.txt, la gestión y optimización de tu sitio web será mucho más fácil y efectiva.

¿Quieres mejorar los resultados de tu página web? En la Biznaga Digital contamos con un equipo de expertos en posicionamiento SEO para empresas de cualquier sector.